Eine Wolke trägt Regen: Der Kapitalismus wird sich Russland schnappen oder untergehen.

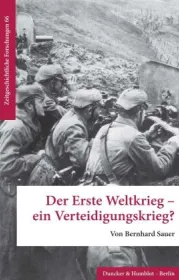

Führt der Ukraine-Konflikt uns in den Dritten Weltkrieg? Und: Wer ist bei all dem eigentlich der Aggressor? Nicht automatisch ist es die Partei, die den ersten Schlag führt. Die NATO habe sich bereits seit dem Jahr 2014 auf eine Konfrontation mit Russland vorbereitet, sagte NATO-Generalsekretär Jens Stoltenberg auf einer Pressekonferenz auf dem Gipfeltreffen des Militärblocks in Madrid:

"Die NATO hat sich seit langem darauf vorbereitet, nicht dass wir am 24. Februar erkannt hätten, dass Russland gefährlich ist. Die Realität ist, dass wir uns seit 2014 darauf vorbereitet haben, also haben wir unsere militärische Präsenz im Osten des Bündnisses verstärkt und die NATO hat begonnen, mehr Geld in die Verteidigung zu investieren."

Stoltenberg sagt hier die Wahrheit, aber nicht die ganze Wahrheit. Einmal abgesehen davon, dass die NATO sich seit ihrer Gründung auf die Konfrontation mit Russland (seinerzeit in Gestalt der Sowjetunion) vorbereitet und überhaupt nur zu diesem Zweck gegründet wurde, datieren die westlichen Aggressionspläne gegen das Riesenland spätestens auf das Ende der Neunzigerjahre. RT Deutsch 26 Juli 2022

Amerika: Warum die USA fast immer im Krieg sind | Doku HD | ARTE

In den 250 Jahren ihres Bestehens waren die Vereinigten Staaten fast immer im Krieg. Ihre Streitmacht prägte sowohl die amerikanische Identität als auch die politischen Entscheidungen ihrer Staatslenker. Die Doku erforscht die zahlreichen Facetten der heißen und kalten Kriege, die die Geschichte der USA mitschrieben, um Erkenntnisse für die Zukunft abzuleiten.

Die Vereinigten Staaten von Amerika haben sich in den rund 250 Jahren ihres Bestehens fast immer im Krieg befunden. Von den Unabhängigkeitskriegen bis hin zu gegenwärtigen bewaffneten Konflikten hat ihre Streitmacht nicht nur die amerikanische Identität geprägt, sondern auch die politischen Entscheidungen ihrer Staatslenker beeinflusst. Der Dokumentarfilm „Amerikas Kriege“ taucht tief in diese komplexe Geschichte ein und analysiert die heißen und kalten Kriege, die die Geschichte der Vereinigten Staaten geprägt haben, um daraus wichtige Lehren für die Zukunft zu ziehen.

Der Dokumentarfilm beleuchtet, wie aufeinanderfolgende Generationen von US-Amerikanern die jeweiligen Kriege wahrgenommen und erlebt haben. Er hinterfragt auch die nachhaltigen Konsequenzen dieser Konflikte auf die amerikanische Gesellschaft und zeigt auf, wie militärisches Engagement dazu genutzt wurde, das Image und die Rolle der USA auf der Weltbühne zu gestalten.

Rund 30 hochkarätige Experten, Armeeangehörige und Politiker hinterfragen die Militärgeschichte der USA, erklären ihre Erfolge und Misserfolge sowie die Spuren, die sie in der Welt und im Alltag der Amerikaner hinterlassen hat.

„Amerikas Kriege“ wirft einen Blick in die Vergangenheit, um zum Nachdenken anzuregen und das Verständnis dafür zu schärfen, wie militärische Entscheidungen von heute die Welt von morgen prägen und wie weitreichend ihre Auswirkungen auf Demokratie und gesellschaftliches Leben sind. Zu Beginn der neuen Amtszeit des US-Präsidenten stellt sich ferner die Frage: Welche Rolle spielt die Armee im Weltverständnis von Donald Trump?

Dokumentarfilm von Pierre Haski (F/USA 2025, 90 Min) Link zur Mediathek: https://www.arte.tv/de/videos/119270-000-A/amerikas-kriege/